8 stycznia 2024

Alert ESET. Wizerunek TVP i programu i9:30 wykorzystany przez cyberprzestępców przy użyciu technologii deepfake

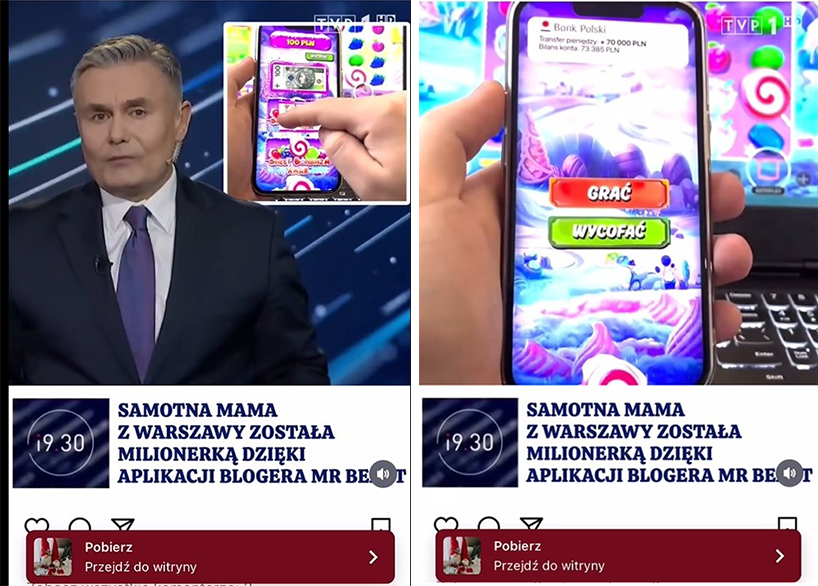

Marek Czyż, prezenter programu informacyjnego i9:30 TVP, jego wizerunek, logo stacji i programu, a także PKO BP i najpopularniejszy na świecie YouTuber, MrBeast, zostali wykorzystani do bezprawnego promowania aplikacji hazardowej. Cyberprzestępcy za pomocą AI stworzyli fałszywe filmy, które pojawiły się w social mediach.

„Samotna mama z Warszawy została milionerką dzięki aplikacji blogera Mr Beast” – taki tytuł ma film przedstawiający rzekomy materiał z serwisu informacyjnego TVP. Marek Czyż ma w nim zachęcać do pobrania aplikacji hazardowej, w materiale pojawia się także rzekoma zwyciężczyni oraz wspomniany influencer, a dla uwiarygodnienia rzekomych przychodów także wizerunek PKO BP i jego aplikacji bankowej. Film kończy się zachętą do klikania w osadzony w nim link i „wejścia do gry”. Co ciekawe, do promowania materiału wykorzystano markę popularnego w Portugalii, ale nieznanego w Polsce medium. To oraz fakt, iż po dokładniejszym obejrzeniu widać pewne niespójności („samotna mama z Warszawy” ma mieć na imię Hanah, a jej wypowiedź i pojawiające się na ekranie screeny z aplikacji zawierają błędy językowe) może wskazywać, że oszustwo zostało opracowane przez zagranicznych cyberprzestępców.

Niestety, aby wypowiedzi Marka Czyża oraz rzekomej zwyciężczyni brzmiały wiarygodnie, cyberprzestępcy wykorzystali technologię deepfake. Tego typu materiały wykorzystują sztuczną inteligencję do tworzenia filmów lub zdjęć z wizerunkiem wybranych osób, które do złudzenia przypominają prawdziwe. Filmy stworzone przez AI pozwalają przypisać prawie każdej osobie dowolne słowa, nawet te, których nigdy nie wypowiedziała. Jedynym warunkiem stworzenia takiego materiału jest dostęp do większej liczby autentycznych nagrań wideo i audio z udziałem danej osoby. To na ich podstawie AI generuje nowy materiał. Osoby publiczne i medialne są więc łakomym kąskiem dla cyberprzestępców wykorzystujących deepfake, ponieważ nagrania z ich udziałem są powszechnie dostępne. Finalnym celem cyberprzestępców sięgających po nowoczesne technologie w ten sposób, jest zwykle wyłudzenie danych lub środków finansowych od nieświadomych użytkowników, a wykorzystanie zaufania, jakim obdarzamy osoby publiczne, to jeden z cynicznych zabiegów. Kliknięcie w takie reklamy, linki, może więc skończyć się pobraniem złośliwego oprogramowania, a nawet utratą pieniędzy.

Oszustwa tego typu są coraz częstsze. Jakiś czas temu głośno było już o innym o filmie wykorzystującym wizerunek najpopularniejszego na świecie Youtubera. Fałszywy MrBeast oferował wtedy nowe iPhone'y za 2 dolary. Z kolei materiały z podobiznami gwiazd BBC Matthew Amroliwala i Sally Bundock oraz Elona Muska zostały wykorzystane do promowania rzekomej okazji inwestycyjnej.

Jeszcze kilka lat temu demaskowanie sfabrykowanych filmów i obrazów było stosunkowo proste, ale z biegiem czasu stało się znacznie trudniejsze. Obecnie coraz trudniej stwierdzić czy dany materiał jest wytworem AI. Narzędzia do tworzenia materiałów deepfake są na wyciągnięcie ręki dla każdego cyberprzestępcy. Bardzo szybko rozwija się technologia związana z klonowaniem głosu. Oszustwa z wykorzystaniem wizerunku znanych osób to jeden wątek, a drugim jest możliwość fabrykowania nagrań z udziałem użytkowników prywatnych.

Dostarczanie materiałów do nagrań deepfake to bowiem zagrożenie związanie z korzystaniem z mediów społecznościowych, o którym rzadko myślimy. Nie dotyczy ono tylko twórców internetowych i celebrytów. Wiele osób, przez lata publikowało materiały wideo, które obecnie mogą posłużyć do kradzieży naszego wizerunku i tworzenia fałszywych wypowiedzi. W ten sposób można oszukać np. naszych najbliższych, a nawet zniszczyć naszą reputację. Niebawem może okazać się, że szantaże czy oszustwa poprzez filmy będą równie częste jak tzw. kradzież „na wnuczka”. Dlatego tak ważne jest dokładne filtrowanie treści, jakie wrzucamy do internetu, a także weryfikowanie informacji, nawet tych z udziałem osób, które znamy lub którym ufamy. Bardzo ważne jest też, żeby jak najwięcej osób miało świadomość tego, że nie wszystkie materiały wideo w sieci są prawdziwe. Rozmawiajmy o tym z dziećmi, osobami starszymi i każdym, kto nie ma wystarczającej wiedzy o świecie cyfrowym

Kamil Sadkowski,

analityk laboratorium antywirusowego ESET

Polecane wydarzenia: